Nvidia Vera Rubin: Cú áp đặt cuộc chơi và "nỗi đau" của những kẻ chậm chân tại CES 2026

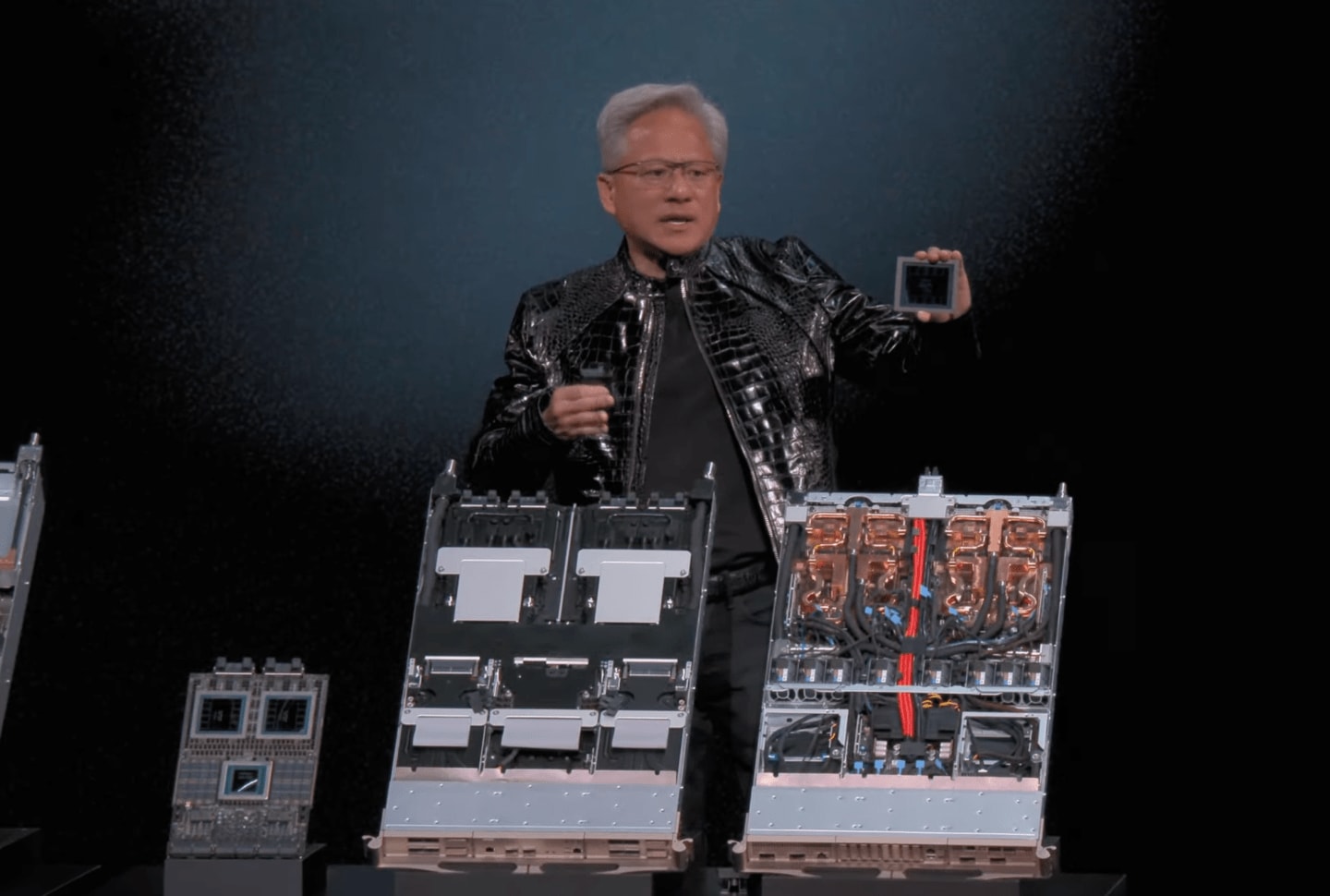

Jensen Huang vừa khiến cả khán phòng CES 2026 nín thở, không phải bằng những mỹ từ về tương lai, mà bằng một tốc độ đào thải tàn nhẫn. Chỉ chưa đầy hai năm sau khi Blackwell thống trị các trung tâm dữ liệu, nền tảng Vera Rubin xuất hiện như một lời khẳng định: Trong kỷ nguyên AI, đứng yên nghĩa là khai tử. Đây không phải bản cập nhật định kỳ; đây là một kiến trúc tính toán mới được thiết kế để nghiền nát những giới hạn mà ngay cả các siêu máy tính mạnh nhất hiện nay đang phải vật lộn.

Khi Blackwell trở thành "di sản" quá sớm

Việc Nvidia duy trì nhịp độ ra mắt sản phẩm hàng năm đang tạo ra một áp lực chưa từng có lên toàn bộ chuỗi cung ứng toàn cầu. Vera Rubin — đặt theo tên nhà thiên văn học tìm ra bằng chứng về vật chất tối — tập trung xử lý các mô hình ngôn ngữ lớn (LLM) vượt ngưỡng 10 nghìn tỷ tham số. Để so sánh, sức mạnh này giúp việc huấn luyện các mô hình AI quy mô tương đương GPT-5 trở nên nhanh hơn gấp 3 đến 4 lần so với thế hệ Blackwell hiện tại.

Trọng tâm của bước nhảy vọt này là GPU Rubin được trang bị chuẩn bộ nhớ HBM4. Với băng thông dự kiến vượt ngưỡng 5TB/s, Nvidia đang trực tiếp phá vỡ "bức tường bộ nhớ" (memory wall) — điểm nghẽn lớn nhất khiến các hệ thống AI tiêu tốn thời gian chờ đợi dữ liệu thay vì xử lý chúng. Tuy nhiên, sự xuất hiện quá nhanh của Rubin đặt ra một câu hỏi hóc búa cho các khách hàng lớn như Microsoft hay Meta: Liệu các khoản đầu tư hàng chục tỷ USD vào Blackwell năm ngoái có kịp thu hồi vốn trước khi chúng trở thành những cỗ máy "lỗi thời" vào cuối năm 2026?

Lời giải cho cơn khát điện hay "án tử" cho mục tiêu xanh?

Nvidia cam kết Rubin mang lại hiệu năng trên mỗi watt điện vượt trội, nhưng sự thật có thể phức tạp hơn. Khi các cụm máy chủ AI ngày càng phình to, việc tối ưu hóa năng lượng ở cấp độ chip chỉ là một phần của bài toán.

Băng thông HBM4 cực đại cho phép giảm đáng kể độ trễ trong quá trình suy luận (inference), từ đó cắt giảm chi phí vận hành cho mỗi truy vấn AI của doanh nghiệp. Tuy nhiên, khi sức mạnh tính toán tăng vọt, tổng lượng điện tiêu thụ của các trung tâm dữ liệu khổng lồ vẫn là một bóng ma ám ảnh các cam kết ESG (Môi trường, Xã hội và Quản trị). Nếu một cụm máy chủ Rubin có thể huấn luyện mô hình nhanh hơn nhưng lại đòi hỏi hạ tầng lưới điện riêng biệt để duy trì, Nvidia đang đẩy quả bóng trách nhiệm sang vai các nhà vận hành hạ tầng và chính phủ.

Hệ sinh thái này không dừng lại ở GPU. Với CPU Vera và bộ điều khiển mạng NVLink thế hệ mới, Nvidia đang xây dựng một "pháo đài" khép kín. Việc đồng nhất hóa các thành phần giúp loại bỏ hoàn toàn nút thắt giao tiếp giữa CPU và GPU, nhưng đồng thời cũng siết chặt vòng vây độc quyền, khiến các đối thủ như AMD hay Intel ngày càng khó có cơ hội chen chân vào các rack máy chủ của các ông lớn đám mây.

Canh bạc chuỗi cung ứng và sự hụt hơi của các đối thủ

Thông điệp từ CES 2026 rất khắc nghiệt: Cuộc đua vũ trang AI sẽ không có điểm dừng để các bên nghỉ ngơi. Nhưng thực tế công nghệ luôn đi kèm với rủi ro sản xuất. Để hiện thực hóa Vera Rubin, Nvidia đang đặt cược toàn bộ vào khả năng cung ứng HBM4 từ SK Hynix, Samsung và quy trình đúc chip tiên tiến (có thể là 3nm hoặc 2nm) của TSMC. Bất kỳ một vết rạn nào trong chuỗi cung ứng này cũng có thể biến Rubin thành một "hổ giấy" trên các slide thuyết trình.

Tầm nhìn của Jensen Huang rõ ràng đã vượt xa việc bán chip thuần túy; ông đang bán một hạ tầng thay thế hoàn toàn cách thế giới vận hành dữ liệu. Trong khi AMD đang nỗ lực bám đuổi với dòng MI400 và Intel cố gắng định vị lại vị thế với Falcon Shores, Nvidia đã kịp dời vạch đích đi xa thêm một dặm.

Dự đoán cho năm 2026: Các doanh nghiệp sẽ không còn lựa chọn giữa "tốt" và "tốt hơn". Họ chỉ có thể chọn tham gia vào guồng quay đào thải điên cuồng của Nvidia để giành lấy lợi thế cạnh tranh, hoặc chấp nhận đứng nhìn các hệ thống AI của mình trở thành đồ cổ chỉ sau một đêm. Cuộc chơi giờ đây không dành cho những kẻ mơ mộng về sự ổn định, nó dành cho những ai dám đốt tiền để đổi lấy tốc độ.